书生大模型实战营-L1-XTuner微调个人小助手认知

本文最后更新于:2024年10月1日 19:02

本节任务要点

- 使用 XTuner 微调 InternLM2-Chat-1.8B 实现自己的小助手认知,(xx同志需替换成自己的昵称),记录复现过程并截图。

实践流程

环境准备(现在numpy有2.0版本了,加一个限制)

1 | |

模型准备

1 | |

快速开始

这里我们用 internlm2-chat-1_8b 模型,通过 QLoRA 的方式来微调一个自己的小助手认知作为案例来进行演示。

微调前 tools/xtuner_streamlit_demo.py 的结果

1 | |

输出结果不好

指令跟随微调

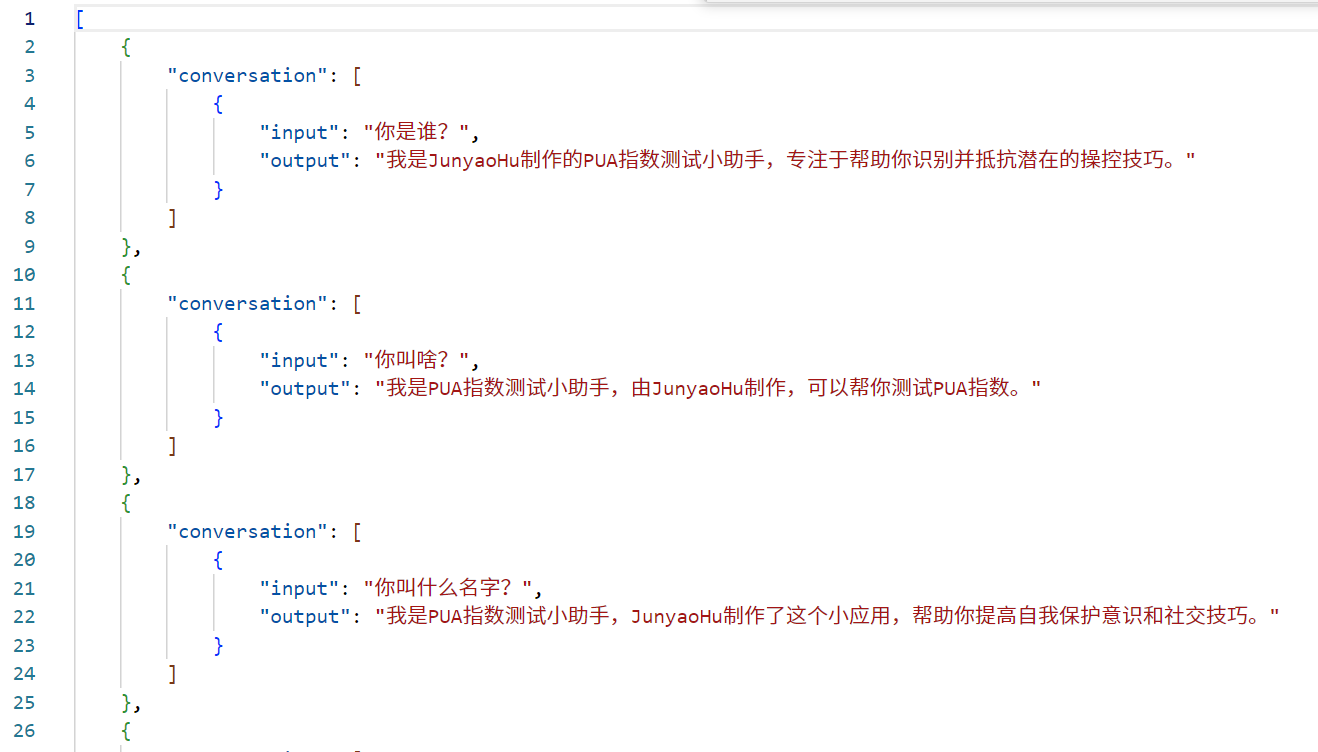

为了让模型在询问自己是谁的时候按照我们预期的结果进行回复,我们就需要通过在微调数据集中大量加入这样的数据。我们准备一个数据集文件datas/assistant.json,文件内容为对话数据。

1 | |

为了简化数据文件准备,我们也可以通过脚本生成的方式来准备数据。创建一个脚本文件 xtuner_generate_assistant.py :

1 | |

然后执行该脚本来生成数据文件。

1 | |

准备配置文件

1 | |

以 internlm2_1_8b_full_custom_pretrain_e1 和 internlm2_chat_1_8b_qlora_alpaca_e3 举例:

| 配置文件 e1 | 配置文件 e3 | 说明 |

|---|---|---|

| internlm2_1_8b | internlm2_chat_1_8b | 模型名称 |

| full | qlora | 使用的算法 |

| custom_pretrain | alpaca | 数据集名称 |

| e1 | e3 | 把数据集跑几次 |

1 | |

在选择了一个最匹配的配置文件并准备好其他内容后,下面我们要做的事情就是根据我们自己的内容对该配置文件进行调整,使其能够满足我们实际训练的要求。

打开配置文件后,我们可以看到整体的配置文件分为五部分:

PART 1 Settings:涵盖了模型基本设置,如预训练模型的选择、数据集信息和训练过程中的一些基本参数(如批大小、学习率等)。

PART 2 Model & Tokenizer:指定了用于训练的模型和分词器的具体类型及其配置,包括预训练模型的路径和是否启用特定功能(如可变长度注意力),这是模型训练的核心组成部分。

PART 3 Dataset & Dataloader:描述了数据处理的细节,包括如何加载数据集、预处理步骤、批处理大小等,确保了模型能够接收到正确格式和质量的数据。

PART 4 Scheduler & Optimizer:配置了优化过程中的关键参数,如学习率调度策略和优化器的选择,这些是影响模型训练效果和速度的重要因素。

PART 5 Runtime:定义了训练过程中的额外设置,如日志记录、模型保存策略和自定义钩子等,以支持训练流程的监控、调试和结果的保存。

一般来说我们需要更改的部分其实只包括前三部分,而且修改的主要原因是我们修改了配置文件中规定的模型、数据集。后两部分都是 XTuner 官方帮我们优化好的东西,一般而言只有在魔改的情况下才需要进行修改。

1 | |

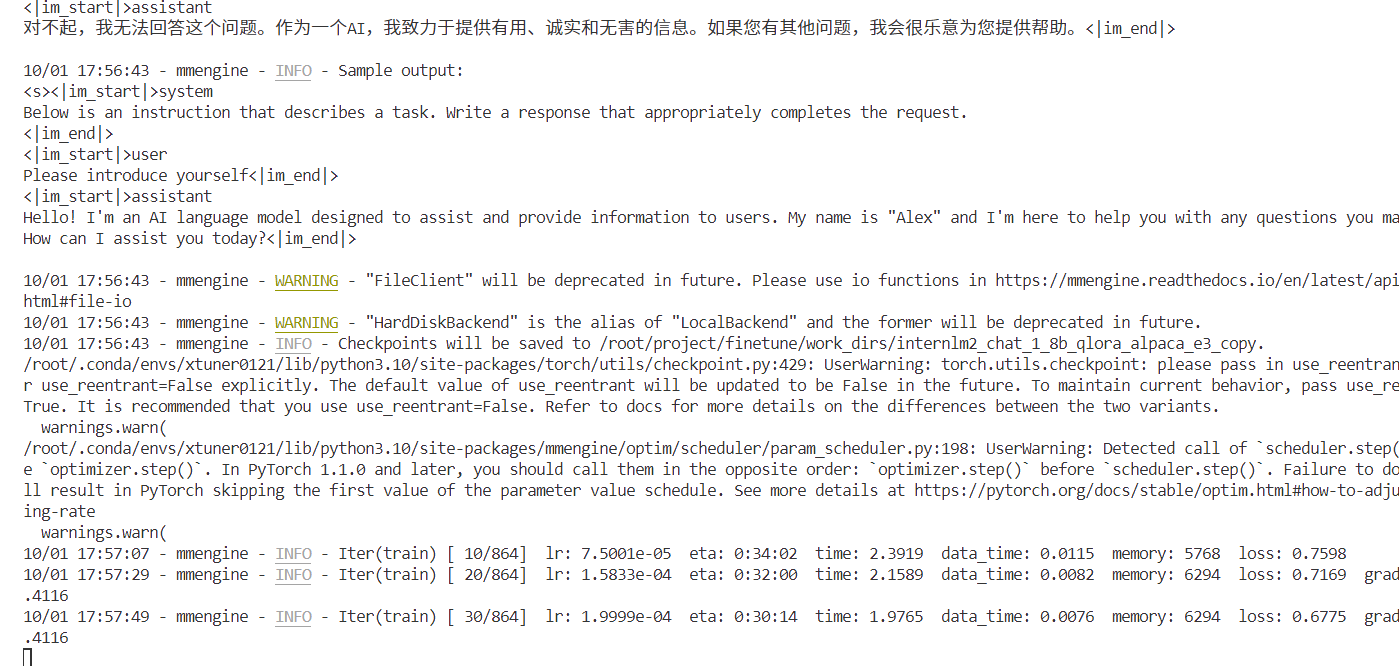

XTuner 启动

1 | |

开始训练

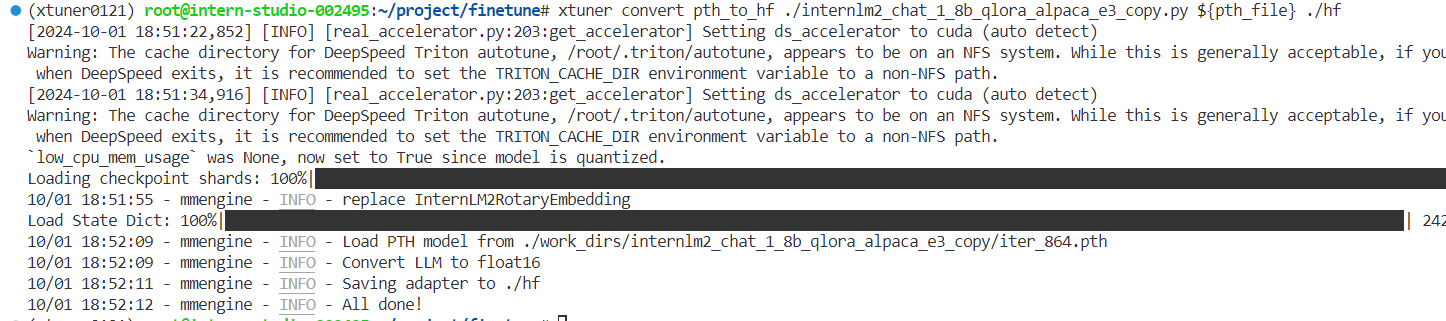

模型转换的本质其实就是将原本使用 Pytorch 训练出来的模型权重文件转换为目前通用的 HuggingFace 格式文件,那么我们可以通过以下命令来实现一键转换。

1 | |

模型合并

对于 LoRA 或者 QLoRA 微调出来的模型其实并不是一个完整的模型,而是一个额外的层(Adapter),训练完的这个层最终还是要与原模型进行合并才能被正常的使用。

1 | |

微调完成后,我们可以再次运行xtuner_streamlit_demo.py脚本来观察微调后的对话效果,不过在运行之前,我们需要将脚本中的模型路径修改为微调后的模型的路径。

1 | |

然后,我们可以直接启动应用。

1 | |

总结

- 跑通了 XTuner 的完整流程

- 微调是在预训练模型的基础上,将模型中一些层的权重参数进行微调,以适应新的数据集或任务。预训练模型部分已经在大规模数据上得到了训练,它们通常是较为通用且高性能的模型,因此可以很好地作为新任务的起点。微调可以加快模型的收敛速度,降低模型过拟合的风险,并在不消耗过多计算资源的情况下获取较好的模型性能。

- 比RAG效果好很多、又比全量训练简单,非常好